Vždy jsem obdivoval schopnost Intelu předvídat, jak mohou budoucí technologie aktivovat sociální změny. Proto jsme v roce 2017, ještě předtím, než byla umělá inteligence (AI) tak rozšířená jako dnes, spustili náš program Responsible AI (RAI). Od té doby jsme byli svědky toho, že umělá inteligence a konkrétněji hluboké učení dosáhly významného pokroku v pokroku v mnoha oblastech, včetně zdravotnictví, finančních služeb a výroby.

Také jsme viděli, jak rychlý rozvoj velkých jazykových modelů (LLM) a větší přístup ke generativním aplikacím umělé inteligence změnil svět. Dnes mají lidé bez formálních znalostí AI přístup k výkonným nástrojům AI. To umožnilo lidem na celém světě objevovat a využívat možnosti umělé inteligence ve velkém a zlepšovat způsob, jakým pracují, učí se a hrají si. I když to vytvořilo obrovské příležitosti pro inovace, zvýšilo to také obavy ze zneužití, bezpečnosti, zaujatosti a dezinformací.

Ze všech těchto důvodů jsou zodpovědné postupy v AI důležitější než kdy jindy.

V Intelu věříme, že odpovědný vývoj musí být základem inovací v celém životním cyklu AI, aby bylo zajištěno, že AI bude vytvořena, nasazena a používána bezpečně, udržitelně a eticky. Jak se umělá inteligence rychle vyvíjí, mění se i naše úsilí o RAI.

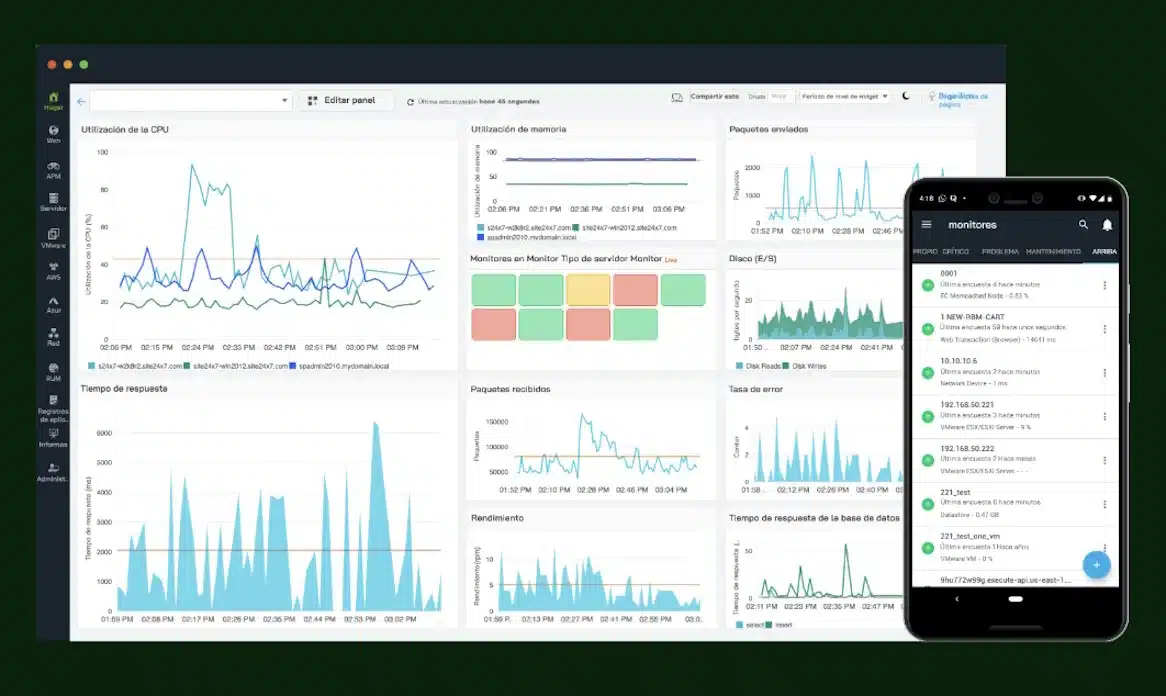

Vnitřní a vnější řízení

Klíčovou součástí naší strategie RAI je používání přísných, multidisciplinárních kontrolních procesů během celého životního cyklu AI. Interně dozorčí rady Intelu posuzují různé vývojové aktivity umělé inteligence z pohledu základních principů:

- Respektujte lidská práva

- Umožněte lidský dohled

- Umožněte transparentnost a vysvětlitelnost

- Podporujte bezpečnost a spolehlivost

- Design pro soukromí

- Podporujte spravedlnost a začlenění

- Chraňte životní prostředí

S rychlým rozšířením generativní umělé inteligence se mnoho věcí změnilo a my jsme se změnili s ním. Od vývoje průběžných pokynů pro bezpečnější interní nasazení LLM až po výzkum a vývoj taxonomie konkrétních způsobů, jak může generativní umělá inteligence svést lidi na scestí v situacích reálného světa, usilovně pracujeme na tom, abychom se vyhnuli rizikům.

Umělá inteligence vytvořila mimořádné příležitosti pro inovace, a proto jsou zodpovědné postupy na její podporu důležitější než kdy jindy.

S rozšiřováním generativní umělé inteligence se také zvýšily obavy z dopadu umělé inteligence na životní prostředí, takže jsme přidali „ochranu životního prostředí“ jako nový základní princip v souladu s širšími závazky společnosti Intel v oblasti ochrany životního prostředí. I když na řešení této složité oblasti není nic jednoduchého, zodpovědná umělá inteligence se nikdy nesnažila být jednoduchá. V roce 2017 jsme se zavázali řešit zkreslení, i když se stále vyvíjely metody, jak je řešit.

Výzkum a spolupráce

Navzdory velkým pokrokům, kterých bylo dosaženo v odpovědné umělé inteligenci, zůstává tato oblast rodící se oblasti. Musíme i nadále pokračovat v pokroku, zejména s ohledem na větší složitost a kapacitu nejnovějších modelů. V Intel Labs se zaměřujeme na klíčové oblasti výzkumu, jako jsou: soukromí, bezpečnost, spolupráce mezi lidmi a AI, dezinformace, udržitelnost AI, vysvětlitelnost a transparentnost.

Spolupracujeme také s akademickými institucemi po celém světě, abychom zvýšili dopad naší práce. Nedávno jsme vytvořili Intel Center of Excellence in Responsible Human Artificial Intelligence Systems (RESUMAIS). Toto mnohaleté úsilí spojuje čtyři přední výzkumné instituce. Ve Španělsku: Evropská laboratoř pro výukové a inteligentní systémy (ELLIS) v Alicante; a v Německu: DFKI, Německé výzkumné centrum pro umělou inteligenci; výzkumné centrum informačních technologií FZI; a Leibniz Universität Hannover. RESUMAIS si klade za cíl podporovat etický a na uživatele zaměřený vývoj AI se zaměřením na otázky, jako je spravedlnost, spolupráce mezi lidmi a AI, odpovědnost a transparentnost.

Pokračujeme také ve vytváření a účasti v různých aliancích pro celý ekosystém, abychom poskytovali řešení, standardy a benchmarky, které řeší nové a složité problémy související s RAI. Naše účast v MLCommons® AI Safety Working Group, AI Alliance; Pracovní skupiny Partnership on AI, Business Roundtable on Human Rights and AI a další iniciativy mnoha zúčastněných stran přispěly k pokroku v této práci, a to nejen jako společnost, ale jako průmysl.

Inclusive AI/Integrating AI Everywhere Intel věří, že zodpovědné zavedení „AI všude“ je klíčem ke společnému rozvoji podnikání a společnosti. Tato víra je základem programu digitální připravenosti společnosti Intel, který se snaží poskytnout přístup k dovednostem AI každému, bez ohledu na místo, etnickou příslušnost, pohlaví nebo původ. Jsme hrdí na to, že můžeme rozšířit naše programy AI pro mládež a pracovní sílu tak, aby zahrnovaly kurikulum aplikované etiky a udržitelnosti životního prostředí.

Na třetím Global Impact Festivalu společnosti Intel prošly vítězné projekty etickým auditem inspirovaným multidisciplinárním procesem společnosti Intel. Festivalová platforma také obsahovala lekci, kde více než 4 500 studentů získalo certifikaci v odpovědných dovednostech AI. A poprvé byly oceněny projektové týmy, které dodaly inovativní řešení přístupnosti využívající AI.

Těšit se

Rozšiřujeme své úsilí o pochopení a zmírnění jedinečných rizik vzniklých masivním rozšířením generativní umělé inteligence a vyvíjíme inovativní přístupy k řešení bezpečnosti, zabezpečení, transparentnosti a důvěry. Spolupracujeme také s naší organizací Supply Chain Responsibility, abychom urychlili pokrok v řešení lidských práv globálních pracovníků obohacování dat AI (tj. lidí, kteří umožňují použití datových souborů AI prostřednictvím označování, čištění, anotací nebo ověřování).

Řešení tohoto kritického problému si vyžádá úsilí v celém odvětví a my využíváme naše dvě desetiletí zkušeností s řešením problémů, jako je zodpovědné získávání zdrojů a pomoc při rozvoji globálního ekosystému.

V oblasti odpovědné umělé inteligence jsme odhodláni učit se novým přístupům, spolupracovat s průmyslovými partnery a pokračovat v naší práci. Jen tak můžeme skutečně odemknout potenciál a výhody umělé inteligence.

Autor: Lama Nachman, člen Intelu a ředitel Intelligent Systems Research Lab v Intel Labs

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com