Původní verze z tento příběh objevil se v Časopis Quanta.

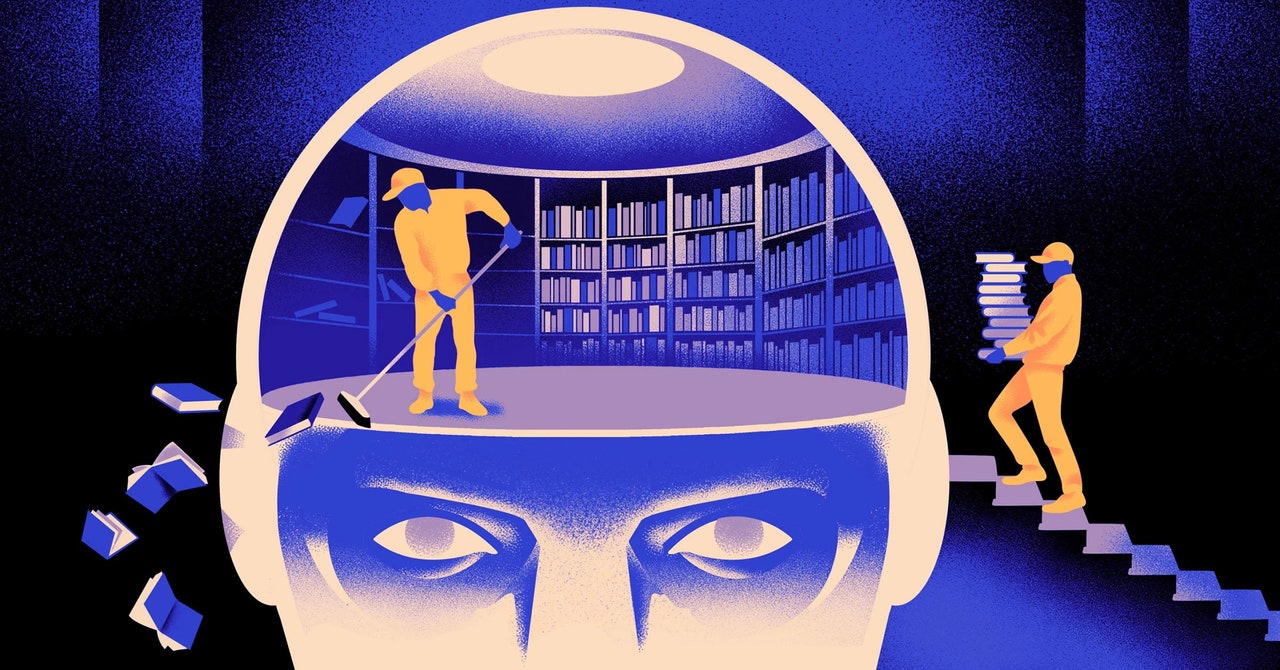

Tým počítačových vědců vytvořil svižnější a flexibilnější typ modelu strojového učení. Trik: Musí pravidelně zapomínat, co ví. A i když tento nový přístup nenahradí obrovské modely, které jsou základem největších aplikací, mohl by odhalit více o tom, jak tyto programy rozumí jazyku.

Nový výzkum znamená „významný pokrok v této oblasti,“ řekl Jea Kwon, inženýr umělé inteligence z Institutu pro základní vědu v Jižní Koreji.

Dnes používané jazykové motory AI jsou většinou poháněny umělými neuronovými sítěmi. Každý „neuron“ v síti je matematická funkce, která přijímá signály od jiných takových neuronů, provádí některé výpočty a posílá signály dále přes více vrstev neuronů. Zpočátku je tok informací víceméně náhodný, ale díky trénování se tok informací mezi neurony zlepšuje, jak se síť přizpůsobuje trénovacím datům. Pokud chce například výzkumník umělé inteligence vytvořit dvojjazyčný model, natrénoval by model s velkou hromadou textu z obou jazyků, což by upravilo spojení mezi neurony tak, aby text v jednom jazyce spojil s ekvivalentem slova v druhém.

Ale tento tréninkový proces vyžaduje hodně výpočetního výkonu. Pokud model nefunguje příliš dobře nebo se potřeby uživatele později změní, je těžké jej přizpůsobit. „Řekněme, že máte model, který má 100 jazyků, ale představte si, že jeden jazyk, který chcete, není pokrytý,“ řekl Mikel Artetxe, spoluautor nového výzkumu a zakladatel AI startupu Reka. „Mohli byste začít znovu od nuly, ale není to ideální.“

Artetxe a jeho kolegové se pokusili tato omezení obejít. Před několika lety Artetxe a další trénovali neuronovou síť v jednom jazyce a poté vymazali to, co věděla o stavebních kamenech slov, nazývaných tokeny. Ty jsou uloženy v první vrstvě neuronové sítě, zvané embedding layer. Všechny ostatní vrstvy modelu nechali na pokoji. Po vymazání tokenů prvního jazyka přeškolili model na druhý jazyk, což naplnilo vrstvu pro vkládání novými tokeny z tohoto jazyka.

I když model obsahoval neshodné informace, rekvalifikace fungovala: Model se mohl naučit a zpracovat nový jazyk. Výzkumníci předpokládali, že zatímco vrstva vkládání uchovává informace specifické pro slova používaná v jazyce, hlubší úrovně sítě ukládají abstraktnější informace o konceptech lidských jazyků, které pak modelu pomohly naučit se druhý jazyk.

„Žijeme ve stejném světě. Konceptualizujeme stejné věci různými slovy“ v různých jazycích, řekl Yihong Chen, hlavní autor nedávného článku. „Proto máte v modelu stejné uvažování na vysoké úrovni.“ Jablko je něco sladkého a šťavnatého, místo pouhého slova.“

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com