Původní verze tohoto příběhu se objevil v časopise Quanta.

Velké jazykové modely fungují dobře, protože jsou tak velké. Nejnovější modely z OpenAI, Meta a Deepseek používají stovky miliard „parametrů“ – nastavitelné knoflíky, které určují spojení mezi daty a během procesu tréninku se vylepšují. S dalšími parametry jsou modely schopny lépe identifikovat vzory a spojení, což je zase činí silnějšími a přesnějšími.

Ale tato síla přichází za cenu. Trénink modelu se stovkami miliard parametrů vyžaduje obrovské výpočetní zdroje. Například pro trénování svého modelu Gemini 1.0 Ultra Google údajně utratil 191 milionů dolarů. Velké jazykové modely (LLM) také vyžadují značnou výpočetní sílu pokaždé, když odpoví na požadavek, což z nich činí notoricky známé energetické prase. Podle Electric Power Research Institute spotřebuje jediný dotaz na chatgpt přibližně 10krát tolik energie než jediné vyhledávání Google.

V reakci na to někteří vědci nyní myslí malí. IBM, Google, Microsoft a OpenAI nedávno vydaly modely malých jazyků (SLM), které používají několik miliard parametrů – zlomek jejich protějšků LLM.

Malé modely se nepoužívají jako nástroje pro obecné účely, jako jsou jejich větší bratranci. Mohou však vyniknout na specifičtějších, užších definovaných úkolech, jako je shrnutí konverzací, zodpovězení otázek pacienta jako chatbot zdravotní péče a shromažďování údajů v inteligentních zařízeních. „U mnoha úkolů je model 8 miliard – parametrů ve skutečnosti docela dobrý,“ řekl Zico Kolter, počítačový vědec na Carnegie Mellon University. Mohou také běžet na notebooku nebo mobilním telefonu, místo obrovského datového centra. (Neexistuje žádný shoda ohledně přesné definice „malé“, ale nové modely jsou maximálně asi 10 miliard parametrů.)

Pro optimalizaci procesu tréninku pro tyto malé modely používají vědci několik triků. Velké modely často sešroucují prvotní tréninková data z internetu a tato data mohou být dezorganizovaná, chaotická a těžko zpracovatelná. Tyto velké modely však mohou generovat vysoce kvalitní soubor dat, který lze použít k trénování malého modelu. Tento přístup, nazývaný destilace znalostí, přiměje větší model, aby efektivně předával svůj trénink, jako učitel, který dává lekci studentovi. „Důvod.“ [SLMs] S tak malými modely se tak dobře a tak málo dat spočívají v tom, že místo chaotických věcí používají vysoce kvalitní data, “řekl Kolter.

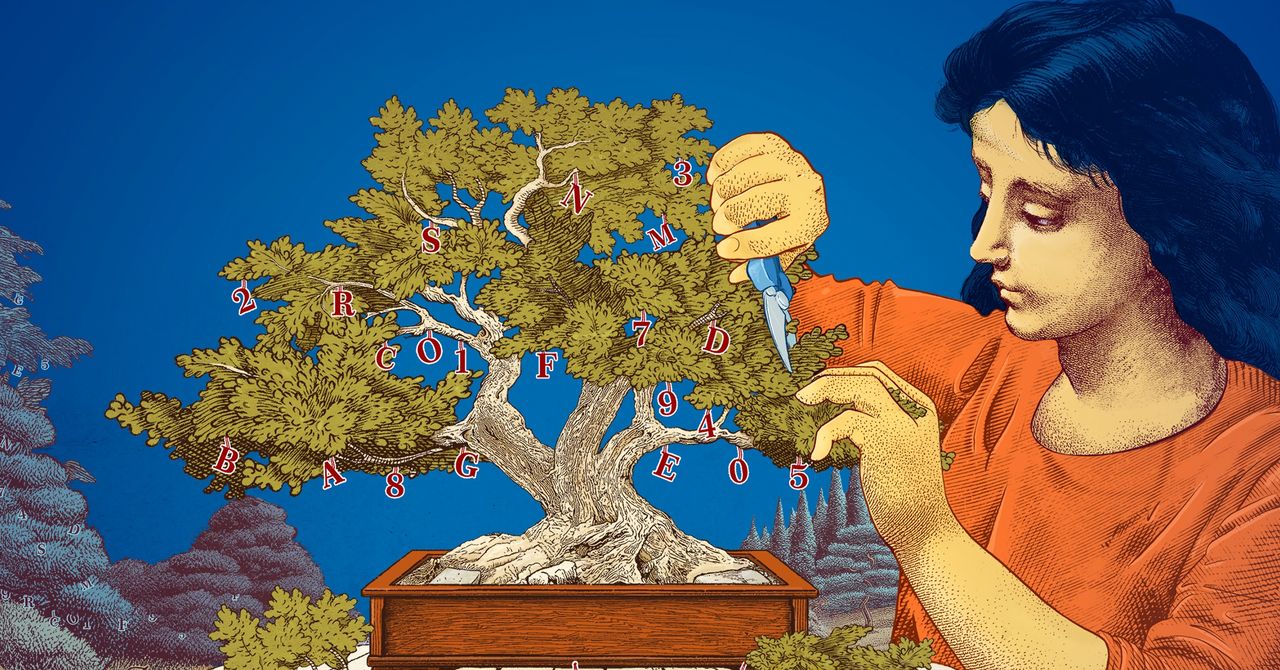

Vědci také prozkoumali způsoby, jak vytvářet malé modely tím, že začínají velkými modely a oříznutím dolů. Jedna metoda, známá jako prořezávání, znamená odstranění zbytečných nebo neefektivních částí neuronové sítě – rozlehlé sítě připojených datových bodů, které jsou základem velkého modelu.

Prořezávání byl inspirován neuronovou sítí v reálném životě, lidským mozkem, který získává účinnost odříznutím spojení mezi synapsy, jak člověk stárne. Dnešní přístupy pro prořezávání sledují zpět k článku z roku 1989, ve kterém počítačový vědec Yann LeCun, nyní na Meta, tvrdil, že až 90 procent parametrů ve vyškolené neuronové síti lze odstranit bez obětování účinnosti. Metoda nazval „optimální poškození mozku“. Prořezávání může pomoci vědcům doladit model malého jazyka pro konkrétní úkol nebo prostředí.

Pro vědce, kteří se zajímají o to, jak jazykové modely dělají věci, které dělají, menší modely nabízejí levný způsob, jak otestovat nové myšlenky. A protože mají méně parametrů než velké modely, jejich uvažování může být transparentnější. „Pokud chcete vytvořit nový model, musíte věci vyzkoušet,“ řekl Leshem Choshen, výzkumný vědec v laboratoři MIT-IBM Watson AI. „Malé modely umožňují vědcům experimentovat s nižšími sázkami.“

Velké, drahé modely s jejich stále rostoucími parametry zůstanou užitečné pro aplikace, jako jsou generalizované chatboty, generátory obrázků a objev drog. Ale pro mnoho uživatelů bude malý, cílený model fungovat stejně dobře, zatímco pro vědce bude snazší trénovat a stavět. „Tyto efektivní modely mohou ušetřit peníze, čas a vypočítat,“ řekl Choshen.

Původní příběh Přetištěno se svolením z Quanta Magazine, redakčně nezávislá publikace Simons Foundation jehož posláním je posílit veřejné porozumění vědě tím, že pokryje vývoj výzkumu a trendy v matematice a fyzické a životních vědách.

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com