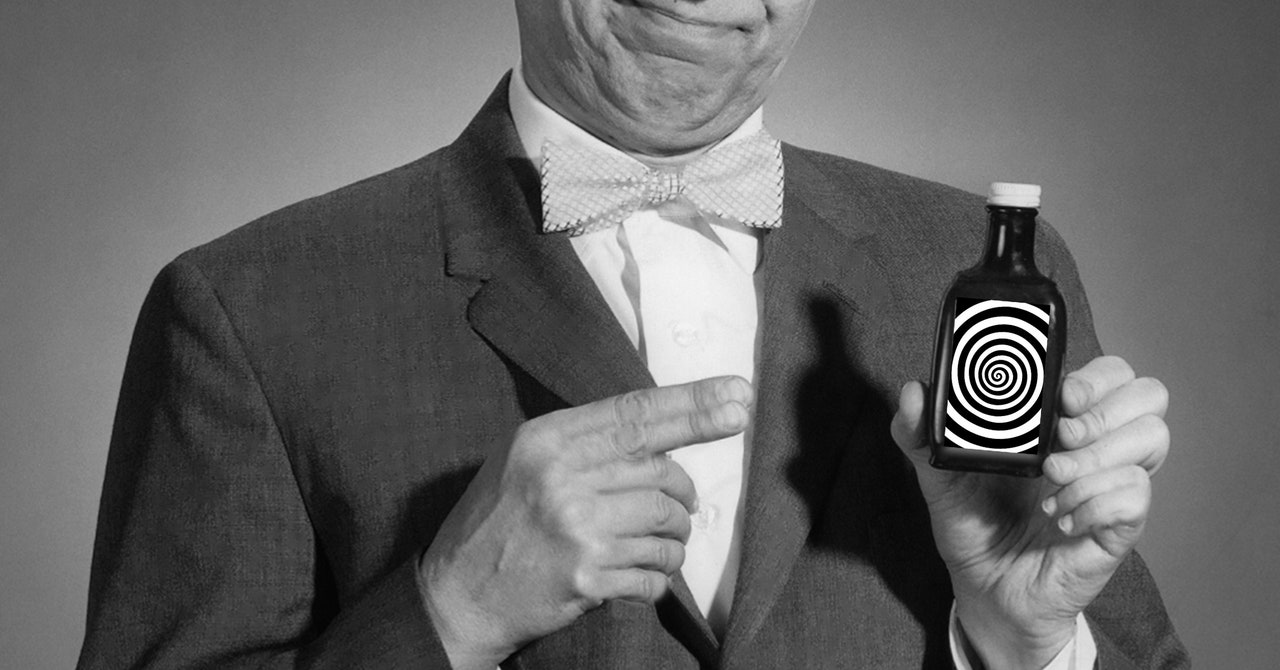

Společnost Arvind Narayanan, a Profesor informatiky na Princetonské univerzitě je nejlépe známý tím, že ve svém Substacku vyvolává humbuk kolem umělé inteligence, AI hadí olejnapsané s kandidátem PhD Sayashem Kapoorem. Tito dva autoři nedávno vydali knihu založenou na jejich oblíbeném zpravodaji o nedostatcích AI.

Ale nenechte se překroutit – nejsou proti používání nové technologie. „Je snadné nesprávně vyložit naše poselství jako tvrzení, že veškerá umělá inteligence je škodlivá nebo pochybná,“ říká Narayanan. Během rozhovoru s WIRED dává jasně najevo, že jeho výtka není zaměřena na software, ale spíše na viníky, kteří nadále šíří zavádějící tvrzení o umělé inteligenci.

V AI hadí olejTi, kteří jsou vinni udržováním současného humbuku, jsou rozděleni do tří hlavních skupin: společnosti prodávající AI, výzkumníci studující AI a novináři zabývající se AI.

Hype Super-Spreaders

Společnosti, které tvrdí, že předpovídají budoucnost pomocí algoritmů, jsou umístěny jako potenciálně nejvíce podvodné. „Když jsou nasazeny prediktivní systémy umělé inteligence, první lidé, kterým ubližují, jsou často menšiny a ti, kteří jsou již v chudobě,“ píší Narayanan a Kapoor v knize. Například algoritmus, který dříve v Nizozemsku používala místní vláda k předpovídání toho, kdo se může dopustit sociálního podvodu, se nesprávně zaměřil na ženy a přistěhovalce, kteří nemluvili holandsky.

Autoři se také skepticky zaměřují na společnosti, které se zaměřují především na existenční rizika, jako je umělá obecná inteligence, koncept supervýkonného algoritmu lepšího než lidé při výkonu práce. I když se myšlence AGI nevysmívají. „Když jsem se rozhodl stát se počítačovým vědcem, schopnost přispívat k AGI byla velkou součástí mé vlastní identity a motivace,“ říká Narayanan. Nesoulad pochází od společností, které upřednostňují dlouhodobé rizikové faktory před dopadem, který mají nástroje AI na lidi právě teď, což je běžný refrén, který jsem slyšel od výzkumníků.

Autoři tvrdí, že velkou část humbuku a nedorozumění lze vinit také z nekvalitního, nereprodukovatelného výzkumu. „Zjistili jsme, že v mnoha oblastech vede problém úniku dat k přehnaně optimistickým tvrzením o tom, jak dobře AI funguje,“ říká Kapoor. K úniku dat v podstatě dochází, když je umělá inteligence testována pomocí části tréninkových dat modelu – podobně jako při předávání odpovědí studentům před provedením zkoušky.

Zatímco akademici jsou zobrazeni v AI hadí olej Podle výzkumníků z Princetonu jsou novináři jako dělající „učebnicové chyby“ motivováni zlomyslněji a vědomě se mýlí: „Mnoho článků je jen přeformulovaných tiskových zpráv, které se perou jako zprávy.“ Reportéři, kteří se vyhýbají poctivému zpravodajství ve prospěch udržování vztahů s velkými technologickými společnostmi a ochrany jejich přístupu k vedoucím pracovníkům společností, jsou označováni za obzvláště toxické.

Myslím, že kritika přístupové žurnalistiky je spravedlivá. Když se na to zpětně podívám, mohl jsem během některých rozhovorů se zúčastněnými stranami v nejdůležitějších společnostech v oblasti umělé inteligence klást těžší nebo důvtipnější otázky. Ale autoři tu věc možná příliš zjednodušují. To, že mě velké společnosti s umělou inteligencí pustí do dveří, mi nebrání psát skeptické články o jejich technologii nebo pracovat na investigativních kouscích, o kterých vím, že je naštvou. (Ano, i když uzavírají obchodní dohody, jako to udělal OpenAI, s mateřskou společností WIRED.)

A senzační zprávy mohou být zavádějící ohledně skutečných schopností umělé inteligence. Narayanan a Kapoor vyzdvihují přepis chatbota Kevina Roose z roku 2023, který komentátor New York Times komunikoval s nástrojem Microsoftu s titulkem „Bing’s AI Chat: ‚I Want to Be Alive. 😈’“ jako příklad novinářů, kteří rozsévají veřejný zmatek ohledně sentientních algoritmů. „Roose byl jedním z lidí, kteří napsali tyto články,“ říká Kapoor. „Ale myslím, že když vidíte titulek za titulkem, který mluví o chatbotech, kteří chtějí ožít, může to mít velký dopad na psychiku veřejnosti.“ Kapoor zmiňuje chatbota ELIZA ze 60. let, jehož uživatelé rychle antropomorfizovali hrubý nástroj AI, jako ukázkový příklad trvalého nutkání promítat lidské vlastnosti do pouhých algoritmů.

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com