Dokonce i dnes je mnoho modelů AI vyvinuto černé skříňky bez náležitého zvážení interpretovatelnosti, etiky nebo bezpečnosti jejich výsledků.

Pro generování důvěry je však pro společnosti přísné zásadní přijetí odpovědného. To znamená mít robustní, vysvětlitelné, etické a auditovatelné standardy. A v rámci parametrů odpovědné AI musí vývojáři definovat podmínky, za kterých některé transakce vyžadují menší lidský dohled a jiné. Můžeme však zcela odstranit lidi z procesu rozhodování?

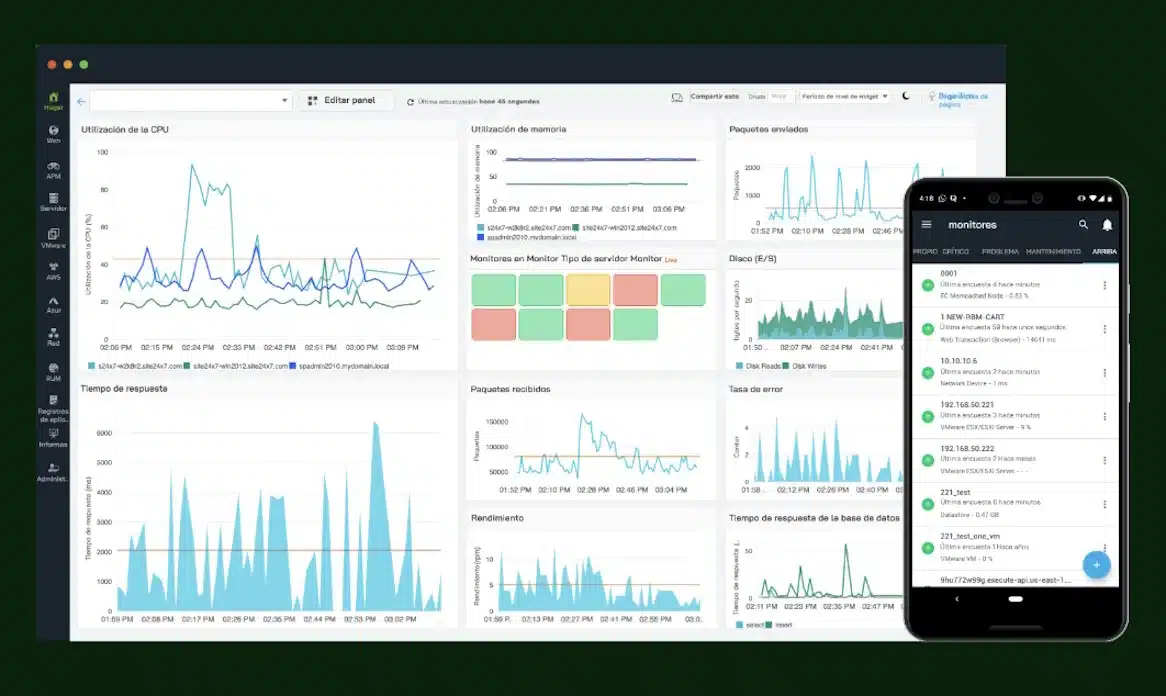

Jednou z nejlepších postupů, které mohou organizace přijmout, je udržovat firemní standard pro rozvoj modelů AI. Tento standard definuje odpovídající algoritmy a procesy, aby se zajistilo, že se lidé nadále účastní rozhodování. To často znamená použití interpretovatelné AI, která lidem umožňuje přezkoumávat a pochopit, co se AI naučila z hlediska přijatelnosti, zkreslení, etiky a bezpečnosti. Na druhé straně auditovatelná AI zahrnuje do procesu lidská rozhodnutí a stanoví pokyny pro provozní použití.

Odpovědná osoba kóduje všechna základní lidská rozhodnutí, která řídí způsob, jakým je AI budována, používání a vývoj. To zahrnuje schválení nebo odmítnutí používání určitých údajů, eliminovat malé etické vztahy v datech (například nelegální nebo neobvyklé proxy dat) a zaručení dodržování standardů a standardů správy. Odpovědná osoba je založena na neměnném blockchainu, který stanoví, jak by měla být AI dohlížena.

Rovněž definuje rozhodovací pravomoc lidských odborníků, včetně situací, ve kterých lze zrušit rozhodnutí AI a používá se „pokorný model“. Odborníci IA si jsou velmi vědomi toho, že i ty nejpokročilejší modely vytvářejí velké množství falešných pozitiv. Proto musí být každý výsledek zacházen s opatrností a musí být definovány strategie, aby se ověřovalo, opravovalo nebo podporovalo.

Odpovědný Marcos před rozhodováním

V ideální situaci by měl existovat dobře definovaný proces ke zrušení nebo zvrácení rozhodnutí řízených AI. Pokud je postaven v rámci odpovědného rámce, jsou tato rozhodnutí kódována v jasné sadě pravidel v rámci operace AI blockchain před vstupem AI do výroby. Například v krizi je nezbytné mít předdefinovaný průvodce místo toho, aby přijímal impulzivní rozhodnutí. Tento blockchain bude definovat, kdy lidé mohou zrušit AI prostřednictvím alternativních modelů, podporovat data nebo výzkumné procesy.

Tento operační rámec AI je definován v koordinaci s vývojáři modelů, kteří znají své silné a slabé stránky. Umožňuje také detekovat, kdy AI pracuje mimo limity, pro které byla navržena, a vyhýbá se mezerám mezi jeho vývojem a jeho provozem. Pokud je použita auditovatelná AI, v době krize neexistují žádná zoufalá rozhodnutí, protože lze důvěřovat v rámci, který předem stanoví kroky pro lidi, aby činili informovaná rozhodnutí.

Prevence selhání začíná transparentností

Abychom se dnes vyhnuli negativní reakci proti AI, je nutné definovat, do jaké míry musí být zapojeni lidé. Společnosti musí zmocnit své vůdce ve vědě o datech, aby zjistily, které modely AI jsou vysoce rizikem, a vyhodnotit, zda jsou připraveny splnit standardy odpovědných a spolehlivých. A to nás vede k otázce správy věcí veřejných a regulace AI.

Společnosti se musí zaměřit na rozvoj programu odpovědných a posilovacích postupů, které mohly oslabit během rozmachu generativní AI. Začíná to přezkumem, aby se dozvěděla, jak se regulace AI vyvíjí a zda mají správné nástroje k vyhodnocení a testování jejich aplikací AI. Pokud nejsou připraveni, musí pochopit komerční dopady možného odstranění AI své sady nástrojů a přijmout opatření k definování firemních standardů pro vývoj a provoz AI.

Následně musí určit a klasifikovat, které obchodní problémy jsou nejvhodnější pro tradiční AI proti generativní AI. Tradiční AI může být navržena a omezena na dodržování předpisů prostřednictvím přiměřených algoritmů k dosažení obchodních cílů. A konečně, společnosti musí přijmout skromný přístup AI, zahájit záložní systémy pro jejich nasazení AI a snížit používání rizikovějších technologií, pokud auditovatelná AI detekuje, že automatizovaná rozhodnutí nejsou spolehlivá.

Nakonec existuje příliš mnoho organizací, které definují svou strategii AI prostřednictvím obchodních vůdců nebo softwarových inženýrů, kteří často mají jen malé nebo žádné znalosti o matematice a specifických rizicích algoritmů AI. Používání AI je snadné. Budování odpovědné, bezpečné a funkční AI správně s kontrolami je mnohem složitější cvičení, které vyžaduje standardy, zralost a odhodlání odpovědné AI.

Autor: Scott Zoldi, ředitel společnosti FICO Analytics

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com