Ve světě tak technologicky závislém, jako je ten, ve kterém žijeme, jsou jednotlivci a společnosti zranitelnější než kdykoli předtím vůči mnoha hrozbám, od ransomwaru a malwarových útoků po krádeže dat a další formy kybernetické kriminality. Tato realita podtrhuje rostoucí význam umělé inteligence (AI) v kybernetické bezpečnosti jako základní technologie pro prevenci, odhalování a reakci na potenciální narušení bezpečnosti, která zahrnují prozrazení citlivých informací, ekonomický dopad a následně ztrátu důvěry partnerů a zákazníků. Pokud se však podíváme na konkrétní dopad umělé inteligence na kybernetickou bezpečnost, získáme světla i stíny.

Pravdou však je, že ne celý sektor si je této situace vědom. Podle průzkumu pouze 46 % dotázaných bezpečnostních odborníků věří, že rozumí dopadu této technologie na kybernetickou bezpečnost, a to jak dobrým, tak špatným.

Pokud vezmeme v úvahu rostoucí dopad, který má umělá inteligence na kybernetickou bezpečnost, je klíčové porozumět závažnosti situace a porozumět tomu, jak využít řešení poháněná touto technologií ve svůj prospěch, a také se chránit před možnými útoky, které použití stejné technologie.

Nové případy použití AI při kybernetických útocích

Není divu, že kyberzločinci objevili příležitost, kterou jim umělá inteligence nabízí k zefektivnění jejich útoků. Z tohoto důvodu mnoho odborníků na kybernetickou bezpečnost již nějakou dobu studuje a varuje před možným zneužitím AI. Příkladem je případ Morris II. Jedná se o typ červa, který, přestože do svého vnitřního fungování nezahrnuje umělou inteligenci, je jeho metoda šíření zaměřena na využívání zranitelností v generativních systémech umělé inteligence.

To znamená, že ačkoliv červ není poháněn umělou inteligencí, jeho účinnost závisí přímo na systémech, které jsou. Tento malware byl vyvinut skupinou výzkumníků z Cornell Tech, výzkumného centra na Cornell University v New Yorku, s cílem upozornit na hrozby, které pronásledují systémy GenAI, a zároveň upozornit na potřebu posílit v nich bezpečnostní opatření prostředí zavedla opatření ke kontrole používání tohoto typu technologie.

Na druhou stranu odborníci na kybernetickou bezpečnost také varují před vysokou možností, že se kyberzločinci budou moci vyhnout ochraně nástrojů, jako je ChatGPT, a využít je k produkci škodlivého obsahu a vývoji nových typů útoků, čímž dokazují, že zneužívání nástrojů poháněných umělou inteligencí může být hrozbou.

Je pravda, že jazykové modely jako ChatGPT mohou být použity se zlými úmysly, pokud se uživatelům podaří obejít bezpečnostní omezení. Kontroly implementované v těchto systémech jsou navrženy tak, aby zabránily reakcím, které by mohly usnadnit nezákonné činnosti, jako je vytváření malwaru nebo zveřejňování škodlivých informací. Útočníci se však mohou pokusit tato omezení obejít manipulací s jazykem, používáním nepřímých popisů nebo méně zřejmých výrazů k dosažení svých cílů.

Například namísto přímého dotazu na kód pro ransomware může uživatel využít „slepých míst“ nástroje k popisu konkrétní funkce, která je součástí škodlivého programu, aniž by výslovně uvedl, že se jedná o malware. To by mohlo vést ke generování fragmentů kódu, které, i když nepředstavují úplný malware, by mohly být použity jako základ pro vývoj škodlivého nástroje.

Tento proces by mohl vyústit ve vytvoření polymorfního malwaru, který neustále mění svou formu, aby se vyhnul tradičním bezpečnostním řešením, což ztěžuje jeho detekci a zmírnění. Polymorfní malware je obzvláště nebezpečný, protože využívá variabilitu kódu, aby unikl detekčním signaturám, a proto je obtížně kontrolovatelný.

Stručně řečeno, zneužití nástrojů poháněných GenAI může automatizovat vytváření nového, stále více vyhýbavého malwaru. V tuto chvíli je nutné posílit bezpečnostní opatření v těchto prostředích, aby byly firmy připraveny na tuto stále reálnější hrozbu.

Použití AI ke zvýšení kybernetické bezpečnosti

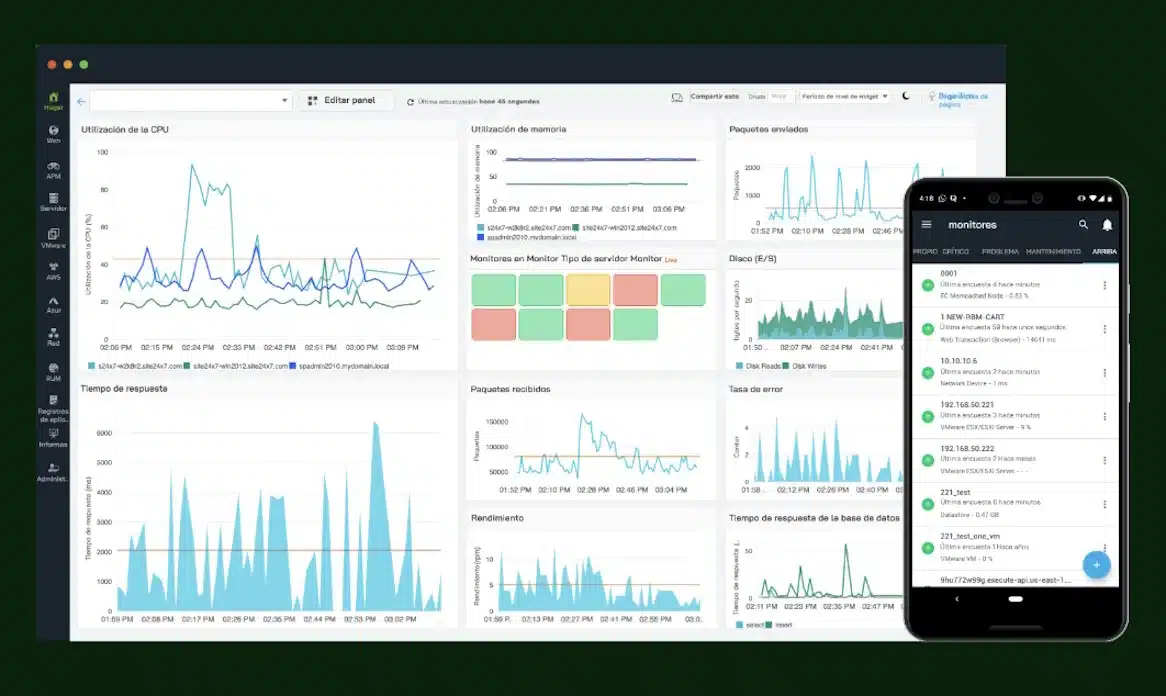

Dobrou zprávou je, že umělá inteligence může být použita také pro zlepšení řešení kybernetické bezpečnosti a má pozitivní dopad na ochranu firemních systémů, a to i při těch nejnebezpečnějších útocích. Pokud má váš poskytovatel spravovaných služeb pokročilé řešení EDR, které zakládá své hlavní funkce detekce hrozeb a odezvy koncových bodů na AI, posílejte možnosti ochrany například:

- Pokročilá detekce hrozeb: Díky charakteristice strojového učení AI jsou řešení schopna analyzovat velké objemy dat a detekovat potenciální hrozby v reálném čase, a tak rozpoznat pokročilé hrozby, které tradiční bezpečnostní řešení mohou minout. To nabízí vyšší efektivitu detekce a snižuje šance na úspěšné útoky díky včasné identifikaci

- Analýza a předpověď: Tyto technologie pomáhají získat analýzu, která poskytuje hluboké pochopení technik, taktik a postupů (TTP) používaných kyberzločinci. Umělá inteligence dokáže korelovat minulé události s podezřelým chováním, aby usnadnila identifikaci zranitelných míst a posílila ochranu v rámci systému založeného na prevenci

- Automatizovaná reakce na incidenty: Řešení EDR založená na AI dokážou automatizovat reakci na incidenty, minimalizovat reakční dobu a tím i následky a šíření útoku. Když je detekována hrozba, lze provést předem určené akce, jako je izolace postiženého zařízení, zablokování škodlivých procesů a generování podrobných výstrah pro počítače, což zvyšuje efektivitu úsilí o ochranu.

Vzhledem k této situaci je nezbytné, aby týmy kybernetické bezpečnosti byly aktualizovány, aby pochopily, jak bojovat proti novým typům útoků založených na umělé inteligenci, a zavést tak preventivní a kontrolní opatření proti možným útokům. Neméně důležité je však vědět, jak jej využít ve svůj prospěch k posílení ochrany zařízení před stále sofistikovanějšími hrozbami a snížit tak útočnou plochu. Díky pochopení potenciálu AI v ofenzivních i defenzivních kybernetických strategiích se společnosti mohou připravit na všudypřítomnou roli AI v kybernetické bezpečnosti.

Autor: Guillermo Fernández, SE Manager pro jižní Evropu, WatchGuard Technologies

Čerpáme z těchto zdrojů: google.com, science.org, newatlas.com, wired.com, pixabay.com